DeCNeC: Detecting CSAM Without the Need for CSAM Training Data

Die Erkennung von Missbrauchsdarstellungen (CSAM) stellt für Strafverfolgungsbehörden weltweit eine große Herausforderung dar. Während bekanntes CSAM, wie das im Rahmen einer Ermittlung beschlagnahmte Material, mithilfe von Hash-Abgleichen (z. B. wahrnehmungserhaltende Hashes wie PhotoDNA) identifiziert werden kann, erfordert die Erkennung unbekannter CSAM-Inhalte den Einsatz fortschrittlicher Methoden – insbesondere solche, die auf KI basieren. Allerdings ist bei KI der Einsatz von CSAM-Trainingsdaten aufgrund ihres hochgradig illegalen Charakters (siehe StGB §184b+c) äußerst problematisch, insbesondere für Forschungseinrichtungen.

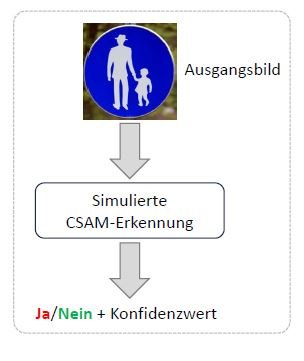

Genau hier setzt das DeCNeC-Projekt an, das sich auf die Erkennung von unbekanntem CSAM konzentriert, ohne auf CSAM-Daten zurückzugreifen. Im Rahmen des Projekts werden neuartige Ansätze aus dem Bereich des Maschinellen Sehens (Computer Vision) erforscht und entwickelt. Die Kernidee besteht darin, separate Konzepte zu kombinieren, um dadurch eine CSAM-Erkennung zu ermöglichen. Zu diesem Zweck werden Klassifikatoren separat auf Erwachsenenpornografieszenen und auf harmlosen Bildern von Kindern in Alltagssituationen trainiert und dann fusioniert, um mögliche Schnittmengen (und damit CSAM) zu identifizieren. Darüber hinaus widmet sich DeCNeC der Erforschung von Bildverbesserungstechniken, um auch mit Bildern minderer Qualität effektiv arbeiten zu können. Parallel dazu werden Lösungsansätze entwickelt, um Herausforderungen wie der problematischen Posendarstellungen (siehe COPINE-Skala) zu bewältigen.

In enger Zusammenarbeit mit Strafverfolgungsbehörden zielt DeCNeC darauf ab, ethisch vertretbare und praxistaugliche Erkennungsmethoden zu entwickeln, mit denen die Ermittlungsarbeit präzise und effektiv unterstützt werden kann.